LG Aimers 학습 내용을 정리한 글입니다

ML : 1. 지도학습 2. 비지도 학습 3. 강화학습

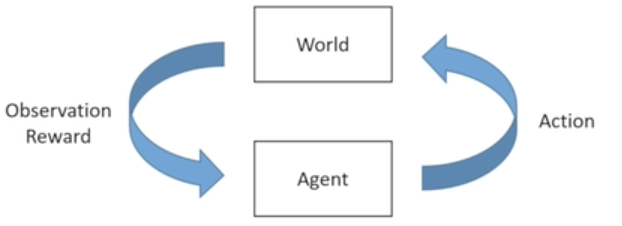

강화학습 : 순차적 의사결정(삶을 살면서 해결해 나가는 모든 문제들)에 관한 것을 담당해서 해결하는 Framework

→ 시행착오를 통해 자연스럽게 문제를 해결하는 방법을 학습해 나가는 것을 수학적으로 Formulation한 형태

- Goal : Select actions to maximize total expected future reward

- 당장 행동을 해서 보상을 받는 것과 일련의 행동들을 해서 나중에 큰 보상을 받는 것 중 더 좋은 것을 골라내야한다.

Markov Decision Processes (MDP) : 강화학습에서 간단하게 풀어낼 수 있는 문제 설정을 정의하는 것

"Process" : discrete time, 시간에 따라서 바뀌는 시스템에서의 문제를 푼다.

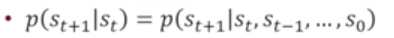

"Markov" : past history볼 필요 없다, 모든 시스템의 모든 정보를(의사결정을 내리기 위해 필요한 모든 정보)관측할 수 있다.

"Decision" : time step, 목표를 최대화 하거나 최소화 해야한다. (reward/cost)

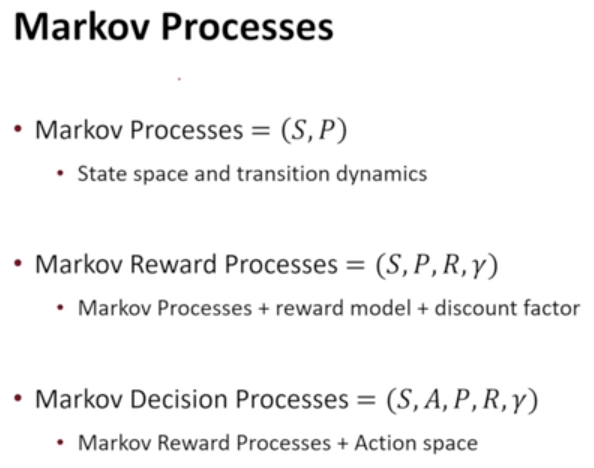

Markov Processes(i.e Markov Chain) : State, Process, P(Transition probability)

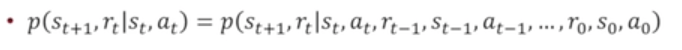

Markov Property : 미래상태가 현재 상태에 확률이 기존 History에 독립적이다.

Markov Reward Processes (MRP) : State, Process, P(Transition probability), R(reward function), γ(discount factor)

Markov Property : 미래상태와 현재 보상을 받는것도 현재 상태에 확률이 기존 History에 독립적이다.

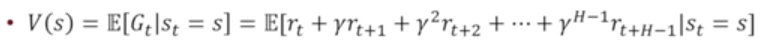

Horizon : 미래를 보고 의사결정을 내릴 때 어디까지 한계를 짓소 미래 의사결정을 할지

infinite: 무한한 Time step까지의 미래, finite : fix된 Horizon H가 존재

→ infinite는 보상합이 무한대로 쉽게 갈 수 있기 때문에, 제한하기 위해 Discount factor(미래에서의 보상은 이만큼 감쇄가 된다)을 도입.

Return (미래 보상합)

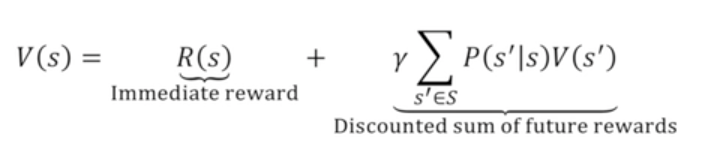

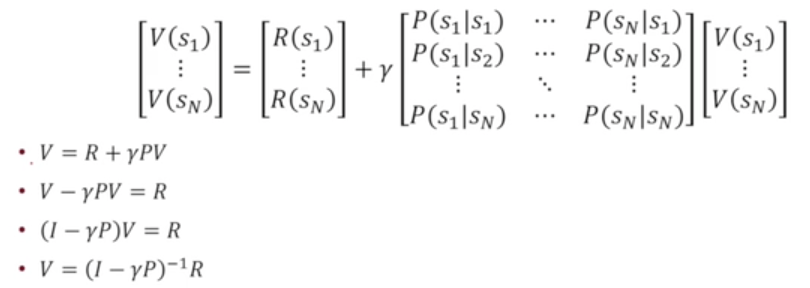

Value Function : 어떤 상태가 얼마나 좋은지, 미래 보상의 수익

→ Bellman equation : 상태가 유한한 경우에 matrix 형태로 나타낼 수 있다.

Dynamic programming(DP)

Markov Decision Processes (MDP) : State, A(Action), Process, P(Transition probability), R(reward function), γ(discount factor)

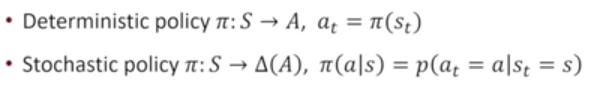

MDP Policies

Policy specifies what action to take in each state.

Deterministic policy : 상태의 함수로서 행동이 나오는 형태

Stochastic policy : 상태에 따라서 행동이 어떠한 확률 분포로 나오는 형태

MDP + Policy = Markov Reward Process

Policy Evaluation : MDP가 주어져 있을 때 그것에 해당하는 Value Function을 찾아내는 것

Optimal Policy 하나가 무조건 존재 (증명은 추후에 작성 예쩡)

Value iteration

Policy iteration

'Add, > LG Aimers' 카테고리의 다른 글

| [LG Aimers] 강화학습3 - Model-Free Control (0) | 2023.07.27 |

|---|---|

| [LG Aimers] 강화학습2 - Model-Free Policy Evaluation (0) | 2023.07.27 |

| [LG Aimers] 지도학습(분류/회귀)5 - Ensemble/Evaluation (0) | 2023.07.26 |

| [LG Aimers] 지도학습(분류/회귀)4 - Advanced Classification (0) | 2023.07.24 |

| [LG Aimers] 지도학습(분류/회귀)3 - Linear Classification (0) | 2023.07.24 |

댓글